学什么

主要是从机器学习的工作流出发,每个阶段主要的工作和工业界流行的技术和概念

主要包括四个学习模块:

- 数据 数据获取、存储、清洗

- 模型 训练、迁移、多模态

- 部署

- 监控 可视化

学习计划

基本学习计划:

- 数据模块

- 一天一个视频,慢慢学

- 模型模块

- 机器学习、深度学习模块部分,快速过一遍

- 模型验证,调优部分慢慢学,基础较差

- 部署 + 监控部分

- 慢慢学

大概一共30多个视频,三周内学完(无意外的情况下),deadline 3-15

In computer science, a trie, also called digital tree or prefix tree, is a type of search tree, a tree) data structure used for locating specific keys from within a set. These keys are most often strings), with links between nodes defined not by the entire key, but by individual characters). - wikepidea

前缀树(又叫做字典树)是一种特殊类型的多叉树,每条边代表一个一个字母,每个节点代表一个字符串(前缀),该字符串由从根节点到当前节点路径字母组成,由于节点间的父子关系,父节点字符串就相当于子节点字符串的前缀,因此称为前缀树。

需要特殊注意的是前缀树的根节点由于没有父节点,代表空字符串

其他的解决方案

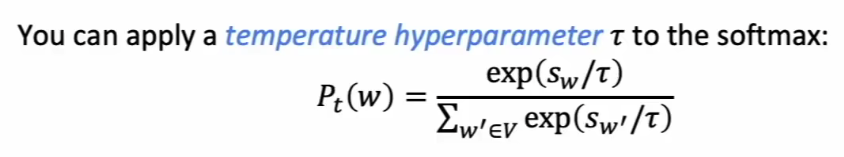

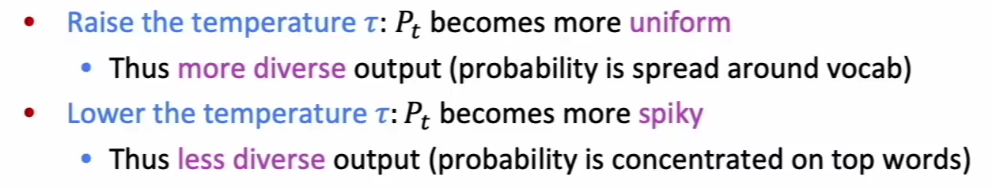

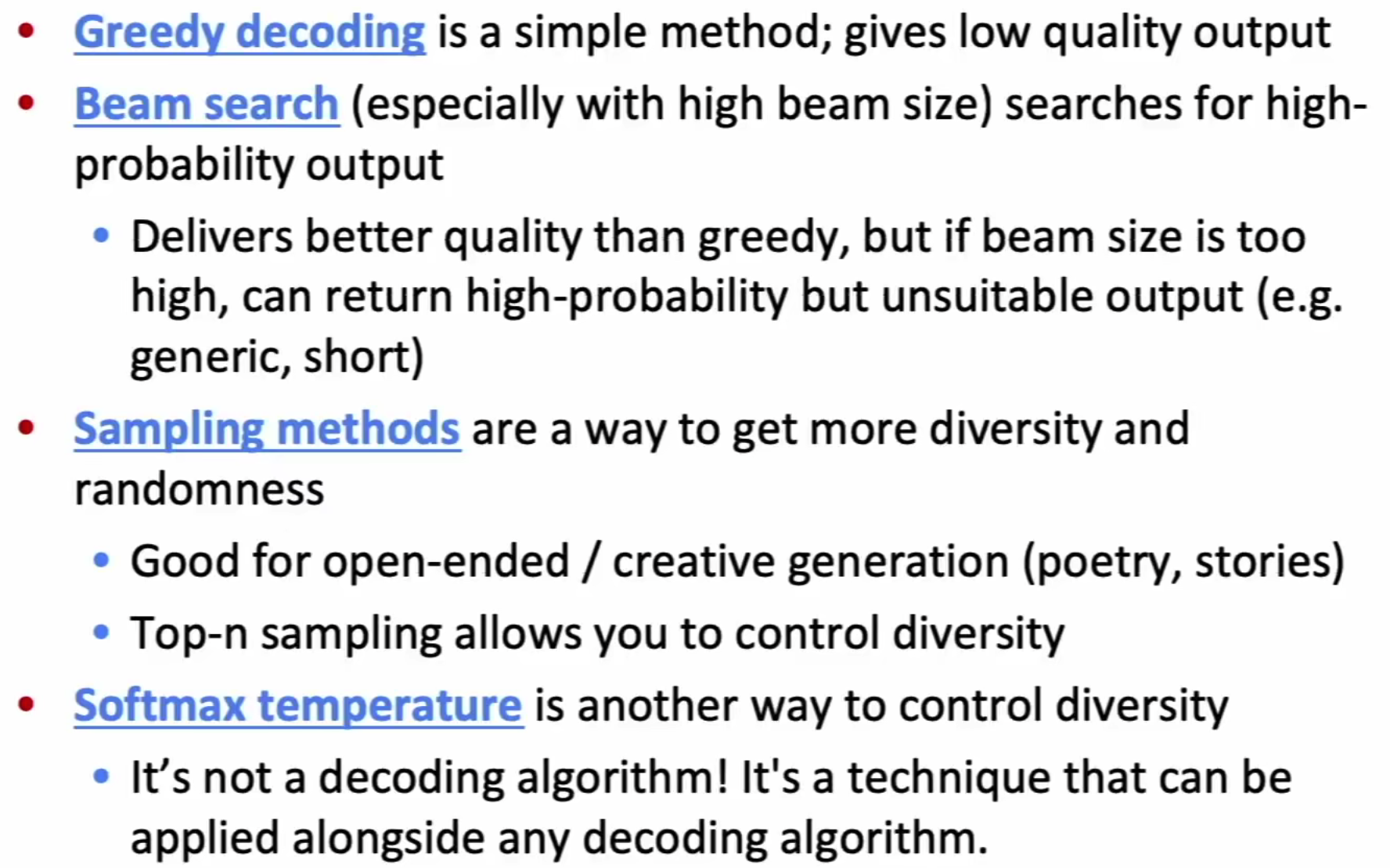

在原始的Softmax函数中添加 temperature hyperparameter: $\tau$ .

关键点是意识到2的幂次是有限

看到重排序就想到回溯法中的排列树问题,按照排列树的标准模板求解即可,注意排除出现前导零的情况,与

复杂度分析:

代码:

1 | public boolean backTrace(int depth, int nLength, Long curNumber, int[] visited, int[] digits){ |

难点在于处理不能用long解决溢出问题

不能用除法,最简单的思路就是被除数(dividend)不断地减除数(divisor),直到减到剩余余数,相减的次数就是结果。该方法的问题就是时间复杂度太高,

复杂度分析:

没有分析的必要,由于只有32位整数,二进制一共只需要移动32次,时间复杂度与空间复杂度均为O(1)

代码实现:

1 | public int divide(int dividend, int divisor) { |

贪心的思路并不难,就是太难想到了

类似于最优解的区域法,针对每个洗衣机,将整个数组划分为左边右边两个子区域,计算左右两个区域的衣服总和,并定会存在总数小于或者大于 平均*区域数量 的区域,如果当前洗衣机衣服多,就将多余的衣服分给缺衣服的区域(给了邻居)

复杂度分析: