docker file 包含一系列命令行,docker通过该文件组织生成镜像,一个docker file文件主要包括四部分:

- 基础镜像信息

- 维护者信息

- 镜像操作指令

- 容器启动时执行指令

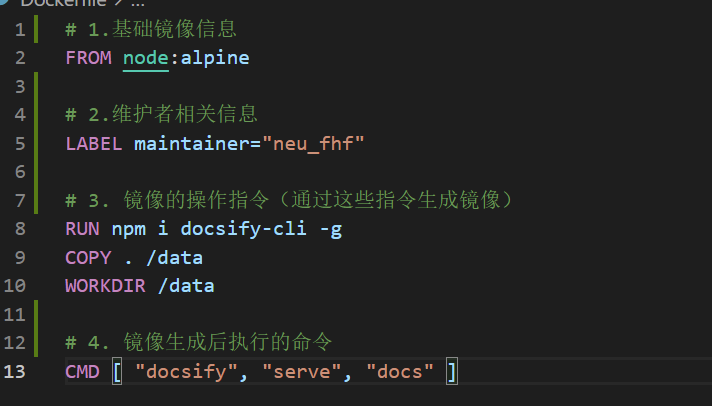

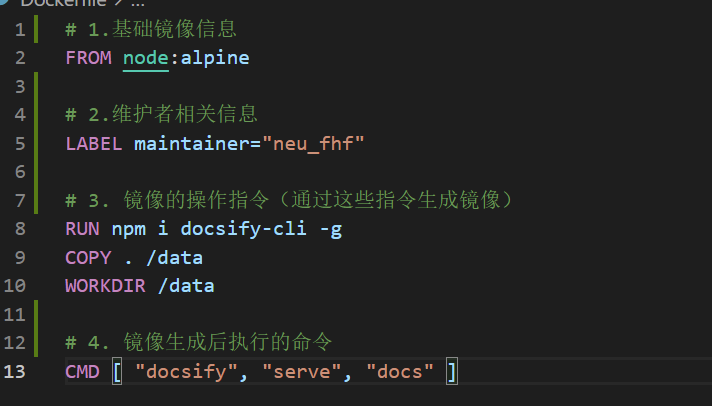

以一个dockerfile为例:

Dockerfile 的指令每执行一次都会在 docker 上新建一层。所以过多无意义的层,会造成镜像膨胀过大

docker file 包含一系列命令行,docker通过该文件组织生成镜像,一个docker file文件主要包括四部分:

以一个dockerfile为例:

Dockerfile 的指令每执行一次都会在 docker 上新建一层。所以过多无意义的层,会造成镜像膨胀过大

The

sklearn.preprocessingpackage provides several common utility functions and transformer classes to change raw feature vectors into a representation that is more suitable for the downstream estimators.

sklearn的preprocessing模块提供了一系列包括标准化、数据最大最小缩放处理、正则化、特征二值化和数据缺失值处理在内的数据预处理模块。

基本操作流程为:

1 | # 1.创建预处理器 transform |

Transformers are usually combined with classifiers, regressors or other estimators to build a composite estimator

将一系列的数据预处理和模型封装在一起,固定处理数据的一系列步骤,调用一次fit和predict完成整个流程,并可使用grid search对pipeline内参数进行统一调试。

构成规则如下(前面处理数据,最后一步输入模型或者完全处理数据):

主要函数:

为了避免模型过拟合,通过添加验证集,模型训练完成后使用验证集验证模型的效果后,再对测试集进行测试。

使用train_test_split函数

1 | >> import numpy as np |

scatter_(dim, index, src, reduce=None) → Tensor

Writes all values from the tensor

srcintoselfat the indices specified in theindextensor. For each value insrc, its output index is specified by its index insrcfordimension != dimand by the corresponding value inindexfordimension = dim.

简单理解就是将 src 张量中的元素散落到 self 张量中,具体选择哪个元素,选择的元素散落到哪个位置由index张量决定,具体的映射规则为:

1 | # 其中 i,j,k 为index张量中元素坐标。 |

别忘了梯度追踪张量必须为float

Only Tensors of floating point and complex dtype can require gradients

当对设置了requires_grad=True的张量进行原地操作时,pytorch会抛出运行错误:

1 | >> X = torch.rand((3,4),requires_grad = True) |